Existe-t-il un moyen pour Google de détecter et de dire si un texte est généré et provient de ChatGPT d’OpenAI ? Et cette détection éventuelle entraînerait-elle une pénalité sur le classement de ce texte dans les résultats de recherche de Google ?

Commençons par la question de base concernant la détection.

Google peut-il détecter et dire si un texte a été rédigé par ChatGPT ?

Oui et non ; en théorie, Google pourrait très probablement détecter qu’un texte est généré par l’IA ou le ChatGPT s’il créait un système à cet effet.

Rien n’indique que Google procède ainsi lors de l’indexation et du classement de différents contenus.

Dans une interview très citée de John Mueller de Google en avril 2022, on lui demande si Google peut comprendre la différence entre un algorithme humain ou un algorithme d’IA qui génère le contenu, ce à quoi il répond : “Je ne peux pas le prétendre”.

D’une manière générale, cette interview a suscité un vif intérêt et un grand débat, car John Muller a également comparé le contenu généré par l’IA à du contenu généré automatiquement et donc à du spam, comme le faisait auparavant Google dans ses Google Search Essentials (anciennement Webmaster Guidelines).

Ce n’est plus la position de Google sur le contenu généré par l’IA.

Pourquoi Google, en tant que moteur de recherche, serait-il intéressé par la détection de contenu provenant de ChatGPT ?

En bref, Google souhaite présenter les meilleurs résultats de recherche possibles aux utilisateurs et s’efforce en permanence d’améliorer la manière dont il le fait. Une grande partie de cette optimisation consiste à empêcher l’affichage de contenu spammy.

Ils décrivent cela de la manière suivante :

“Le contenu spammeur généré automatiquement (ou “auto-généré”) est un contenu qui a été généré de manière programmatique sans rien produire d’original ni apporter une valeur ajoutée suffisante ; au contraire, il a été généré dans le but premier de manipuler les classements dans les moteurs de recherche et non d’aider les utilisateurs.“

Google Search Central

La raison en est que le contenu généré automatiquement par différents types de scripts était de très mauvaise qualité et contenait principalement des mots-clés, dans le but de manipuler les résultats de recherche de Google.

C’est pourquoi Google a essayé de détecter ce type de contenu afin de le supprimer des SERP et de préserver l’intégrité de ses résultats de recherche.

L’idée était qu’en se concentrant sur un contenu de haute qualité, généré par des êtres humains, Google pourrait offrir une meilleure expérience à ses utilisateurs et maintenir la crédibilité de son moteur de recherche.

Mais avec l’essor des différents nouveaux types d’IA (apprentissage automatique, GAN, ou autre), les spécialistes du marketing et les rédacteurs ne les utilisent plus uniquement pour générer une quantité infinie de contenu indésirable, mais ils utilisent ces systèmes pour créer un contenu plus important, meilleur et plus utile pour les utilisateurs.

C’est pourquoi la question de savoir si Google veut faire la différence entre le contenu généré par l’homme et le contenu généré par l’IA devient beaucoup moins claire.

Comment Google pourrait-il détecter le contenu de ChatGPT ?

Pour comprendre comment Google repère un texte provenant d’un système d’IA comme ChatGPT, il faut savoir comment fonctionnent ces modèles de langage.

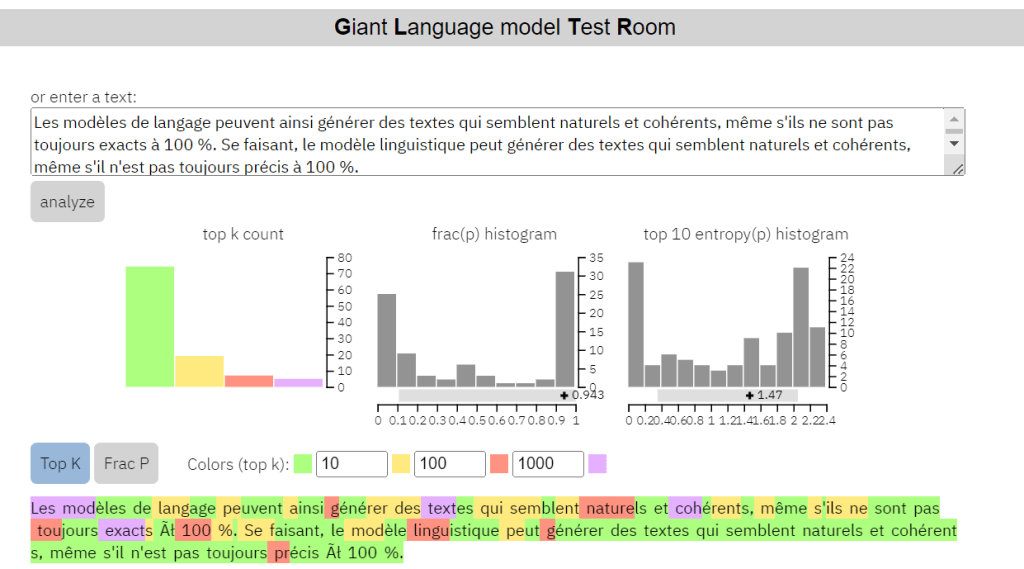

Un modèle de langage fonctionne sur la base de probabilités et peut prédire le mot suivant dans une phrase en fonction des mots qui l’ont précédé. Pour ce faire, il analyse les modèles et les statistiques de la langue dans un vaste corpus de textes et utilise ces informations pour prédire quels mots sont susceptibles de suivre une séquence de mots donnée. Ce faisant, un modèle de langage peut générer un texte qui semble naturel et cohérent, même s’il n’est pas toujours exact à 100 %.

Il existe différents exemples de démonstrations de ces contrôles visant à déterminer si un texte a été généré par une intelligence artificielle.

Le GLTR est un outil qui permet l’inspection judiciaire d’un texte afin de déterminer s’il a été écrit par une personne ou par une IA.

Il a été mis au point par une équipe de chercheurs du laboratoire d’IA MIT-IBM Watson et de Harvard NLP et permet aux utilisateurs d’analyser l’empreinte visuelle d’un modèle de langage sur un texte d’entrée.

Avec le GLTR, chaque texte est analysé en fonction de la probabilité que chaque mot soit le mot prédit compte tenu du contexte à gauche. Si le mot utilisé figure parmi les 10 premiers mots prédits, l’arrière-plan est coloré en vert ; pour les 100 premiers mots attendus, il est coloré en jaune ; pour les 1000 premiers, il est coloré en rouge ; sinon, il est coloré en violet.

Le GLTR offre les caractéristiques suivantes :

- La possibilité d’essayer des échantillons de textes et de voir si vous pouvez repérer la différence entre un texte généré par une machine et un texte généré par un être humain.

- Des histogrammes qui présentent des statistiques sur le texte, notamment la fraction de probabilité du mot réel divisée par la probabilité maximale de tout mot à une position donnée, et l’entropie le long des 10 premiers résultats pour chaque mot.

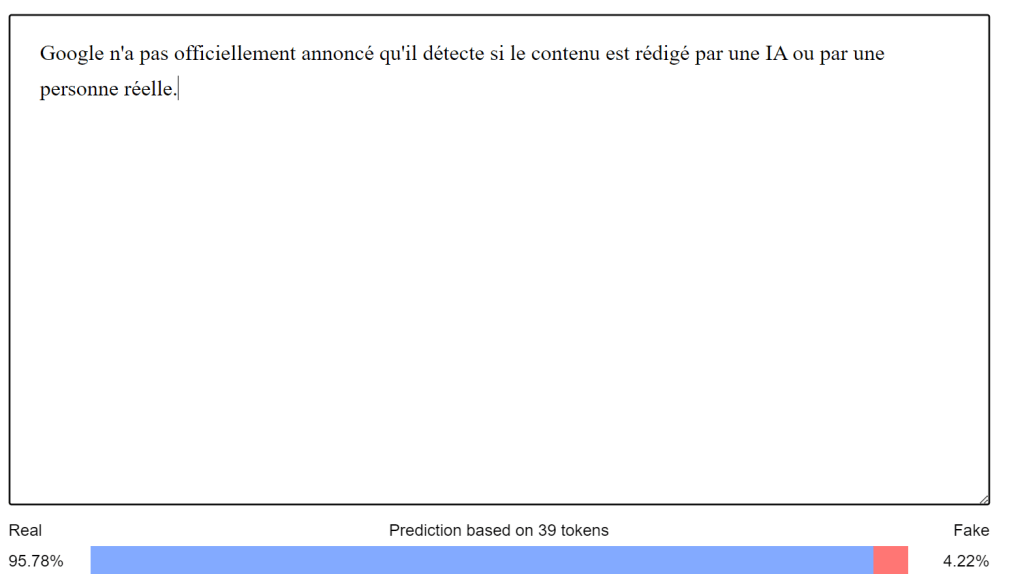

Un autre script détectant le contenu écrit par l’IA est le “GPT-2 Output Detector Demo” de Huggingface.

Vous pouvez l’essayer ici : https://huggingface.co/openai-detector/

Il convient de noter que ces exemples et ces détecteurs sont construits sur le modèle GPT-2 NLG. Comme ChatGPT est construit sur le modèle GPT-3 plus avancé, il sera plus difficile à détecter (il semble toujours détecter le modèle GPT-3).

Au fur et à mesure que ces modèles se développeront, ils seront de plus en plus avancés et ressembleront donc de plus en plus à l’écriture humaine. Dans la démo GLTR, cela signifierait des histogrammes qui auraient la même apparence, qu’ils soient écrits par un humain ou par une IA.

C’est peut-être aussi la raison pour laquelle OpenAI et d’autres plateformes similaires travaillent sur des moyens de permettre à des acteurs comme Google et d’autres moteurs de recherche d’identifier si un texte provient d’une IA en mettant en place une sorte de filigrane dans le texte.

Ce signal secret intégré dans le texte généré indiquerait alors la source.

Il ne s’agit pas seulement de permettre la vérification d’un texte généré principalement à des fins de référencement – comme si quelqu’un utilisait ChatGPT pour le référencement – mais de prévenir le plagiat par réécriture de contenu ou l’usurpation d’identité en détournant le style d’écriture d’autrui.

Que nous dit Google ?

Google n’a pas officiellement annoncé qu’il détecte si le contenu est rédigé par une IA ou par une personne réelle.

Toutefois, dans le cadre des discussions sur le contenu généré par l’IA, même avant l’introduction de ChatGPT, Google a déclaré qu’il n’était pas opposé au contenu généré par l’IA, mais qu’il se concentrait plutôt sur la question de savoir s’il s’agissait d’un contenu utile ou non.

Lisez notre article détaillé sur les raisons pour lesquelles Google n’est pas opposé au contenu généré par l’IA ou sur la question de savoir si le contenu généré par l’IA est contraire aux directives. Il s’agit d’une idée fausse répandue parmi de nombreux spécialistes du marketing SEO.

Cela s’inscrit parfaitement dans la longue histoire des efforts déployés par les géants de la recherche pour lutter contre le spam et le contenu généré uniquement dans une optique de référencement, plutôt que dans l’intérêt de l’utilisateur.

D’une manière générale, Google est l’une des entreprises les plus favorables à l’IA dans le monde et figure depuis de nombreuses années parmi celles qui investissent le plus dans la recherche sur l’IA.

“Elle (l’IA) peut rendre les humains plus productifs que nous ne l’avons jamais imaginé”

Sundar Pichai, PDG de Google